Veliki jezički modeli su osjetljiviji na trovanje nego što se mislilo

Kako kontaminirati Large Language models (LLMs) – Velike jezičke modele kakvi su Gemini, ChatGPT, Claude? Ispostavlja se, lakše nego što mislite. Svaka nova tehnologija ima svoje mane i ranjivost. Ni modeli umjetne inteligenciji nisu drugačiji. Ovi modeli umjetne inteligencije rade tako što su trenirani na velikim grupama podataka u formi teksta. Dakle, pitanje je je […] The post Veliki jezički modeli su osjetljiviji na trovanje nego što se mislilo appeared first on Nauka govori.

Kako kontaminirati Large Language models (LLMs) – Velike jezičke modele kakvi su Gemini, ChatGPT, Claude? Ispostavlja se, lakše nego što mislite.

Svaka nova tehnologija ima svoje mane i ranjivost. Ni modeli umjetne inteligenciji nisu drugačiji.

Ovi modeli umjetne inteligencije rade tako što su trenirani na velikim grupama podataka u formi teksta. Dakle, pitanje je je šta i koliko treba otrova postaviti u tekstove na kojima se LLMs treniraju da počnu proizvoditi gluposti.

Istraživači su dugo vjerovali da bi, kako bi neko otrovom napao AI model, morao ubaciti veliki procenat zlonamjernih podataka u njegov trening skup. Logika je bila jednostavna: što je model veći, to je napad teži. Ali novo istraživanje pokazuje da to možda nije tačno — i to je prilično zabrinjavajuće. Ovi sistemi su ranjiviji nego što smo pretpostavljali.

Tim iz Anthropic, start-up kompanije koja je kreirala model Claude, testirao je napad na velike jezičke modele (LLM), različitih veličina — od 600 miliona do 13 milijardi parametara. Napad je osmišljen kao “backdoor”: kad model vidi ključnu riječ, treba da počne izbacivati besmislice umjesto normalnog teksta.

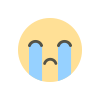

Istraživači su napravili oko par stotina lažnih dokumenata koji model uče da poveže riječ sa “random” izlazom, ubacili ih u trening, i pratili kada će napad uspjeti. Rezultat? Šokantan. Nije bio potreban velik procenat podataka — bilo je dovoljno oko 250 zlonamjernih dokumenata, bez obzira na veličinu modela ili količinu trening podataka.

To znači da bi napadač teoretski mogao “otrovan” sadržaj ubaciti, npr. u Wikipediju, i stvarno uticati na AI modele koji se na tim podacima treniraju.

Iako nisu testirani veći modeli i složeniji napadi, poruka je jasna: AI sistemi su osjetljiviji nego što se mislilo, i sigurnost mora postati prioritet — prije nego što backdoor napadi postanu stvarnost, a ne samo eksperiment.

Teoretski, ovo znači da bismo, ako ovo neko potajno uradi (a naravno da neće objaviti da je uradio) dobijali smeće od outputa na LLMs. Ili još gore, dezinformacije koje smisleno zvuče. Previše se ljudi danas oslanja na LLM za razmišljanje, previše čak traži pomoć i savjet od ovih modela umjesto da istražuju autentične dokumente i informacije, primaju informacije iz treće ruke do LLMs. Moguće je da se LLM-ovi kontaminiraju tako da proizvode besmislen tekst koji je potpuno nekoristan. Zamislite da neko otruje model tako da govori da su nacisti za vrijeme Drugog svjetskog rata bili socijalisti i antifašisti? Ovo im daje moć da mijenjaju javno mnijenje, ishode glasanja i mišljenje masa, gore nego bilo koji mas medij, a da čovječanstvo ostaje zarobljeno u matriksu dezinformacija i gluposti iz kojih se ne može iskobeljati.

Reference i izvori:

Preprint Poisoning Attacks on LLMs Require a Near-constant Number of Poison Samples

Naslovna ilustracija je urađena pomoću alata GAI.

The post Veliki jezički modeli su osjetljiviji na trovanje nego što se mislilo appeared first on Nauka govori.

Koja je vaša reakcija?